Explainable AI

Warum es wichtig ist, dass wir die Ergebnisse von KI-Systemen verstehen.

Explainable AI

Explainable AI oder XAI (eXplainable Artificial Intelligence) ist Teil der dritten KI-Generation und beschreibt das systematische Erklären und Validieren des maschinellen Lernens unter Einbeziehung der Anwender:innen.

Intensive Forschung der letzten Jahrzehnte brachte eine Vielzahl neuer und scheinbar intelligenter Algorithmen im Bereich des maschinellen Lernens hervor. Die darauf aufbauenden künstlich intelligenten Systeme sind vielseitig und gewinnbringend einsetzbar – von automatisierten Diagnoseverfahren bis hin zur Sprach- und Texterkennung. Der hohe mögliche Nutzen wird jedoch überschattet von der Undurchsichtigkeit der Technologie. Es resultieren hochkomplexe Modelle, deren Ausgabe lediglich beobachtet, aber selten verstanden werden kann. Das innere Funktionieren bleibt dem:der Nutzer:in also verborgen; der:die Anwender:in erhält eine Black-Box. Diese Undurchsichtigkeit führt dazu, dass intelligente Systeme vor ihrem produktiven Einsatz nicht hinreichend validiert werden können. Der:die Nutzer:in muss schließlich hoffen, dass das Modell die richtigen Zusammenhänge erlernt und nicht falsche bzw. unerwünschte Eigenschaften des Inputs in Betracht zieht.

Bisher werden zumeist manuelle Tests eingesetzt, um trotzdem das Vertrauen in einen korrekten Betrieb zu gewinnen. Diese sind jedoch lediglich in der Lage, Soll- und Ist-Werte zu vergleichen, und bieten damit nur eine oberflächliche Betrachtung mit sehr limitiertem Mehrwert. Die Auswirkungen der fehlenden Validierung sind mitunter folgenschwer und erlauben fehlerhaften intelligenten Systemen, im Produktivbetrieb hohen Schaden zu bereiten. Modellen ist es so unter anderem möglich, zu „schummeln“. Sie können stark vereinfachte Annahmen treffen, die lediglich auf die Trainings-, aber nicht auf Realdaten zutreffen. Beispielhaft kann hier das Erkennen von Schiffen durch die bloße Anwesenheit vieler blauer Pixel, dem umgebenden Wasser, genannt werden. Andere Modelle verstoßen gegen komplexere Anforderungen, wie zum Beispiel gegen ethische Grundsätze. Hier schlagen traditionelle Vorgehensweisen der Validierung mit noch größerer Wahrscheinlichkeit fehl.

XAI-Methoden können hier helfen.

Begriffsverwirrung XAI: Methodengruppe oder US-Unternehmen?

Die Abkürzungen XAI / xAI werden häufig verwendet, um eine Gruppe von Methoden der erklärbaren künstlichen Intelligenz (Explainable Artificial Intelligence) zu beschreiben. Diese Seite beschreibt diese Methoden und unsere Erfahrungen damit. Sie ist nicht mit der kürzlich gegründeten Organisation xAI verbunden. Als Beratungsunternehmen, dass seit Jahren mit XAI-Methoden arbeitet, verzeichnen wir ein erhöhtes Interesse an dieser Seite.

Wie stehen XAI-Methoden im Zusammenhang mit Elon Musks neuem Unternehmen xAI Corp.?

Die Mission der Organisation “Understanding the Universe” ist in grob mit XAI-Methoden vereinbar. Sie ermöglichen uns die Qualitätskontrolle von ML-Modellen und erlauben die Nutzung des erlernten Wissens für Business-Entscheidungen oder für akademische Forschung in (gewissem Maße).

Bei genauerer Betrachtung (und abgesehen von offensichtlichen strategischen Zielen) liegt der Schwerpunkt der xAI-Organisation anscheinend auf der Erforschung von Large Language Models (LLMs) und General Artificial Intelligence (AGI). Der Begriff AGI verursacht viel Verwirrung und LLMs sind die komplexesten und am wenigsten erklärlichen ML-Modelle, die wir bisher gesehen haben. XAI-Methoden für LLMs sind rar und bleiben ein weitgehend ungelöstes Forschungsproblem.

Elon Musk präsentierte ein Team von 12 (ausschließlich männlichen) Personen mit starken algorithmischen Fähigkeiten und Erfolgsbilanzen, legt aber keinen Schwerpunkt auf Transparenz, Erklärbarkeit und die ethische Zielen, im Allgemeinen mit XAI-Methoden in Verbindung gebracht werden. Daher scheint es, dass die xAI-Organisation keine Dienstleistungen oder Methoden anbieten wird, um diese Ziele zu verfolgen, und möglicherweise nicht die Werte der XAI-Forschungsgemeinschaft teilt.

"Komplexe KI-Modelle produzieren Ergebnisse, die oft schwer nachvollziehbar sind. Menschen akzeptieren dies zu Recht nicht. Kein:e Arzt:Ärztin würde eine:n Patient:in operieren, bloß weil ein:e Kolleg:in dies unbegründet als beste Therapie angibt. Zumindest würde der:die Arzt:Ärztin verstehen wollen, welcher Gedankengang der Prognose zugrunde liegt und auf welchen Symptomen die Empfehlung basiert. So ist es die Aufgabe von KI-Expert:innen, Systeme zu entwickeln, die das eigene Agieren nach außen hin transparent machen und so die Black-Box öffnen. Hier haben KI-Systeme aber auch einen Transparenz-Vorteil gegenüber menschlichen Entscheider:innen: Sie sagen einem ehrlich, wie sicher sie sich sind."

Mit Explainable AI bekommen KI-Systeme ihren angemessenen Platz

Die Disziplin „Explainable Artificial Intelligence“ (XAI) versucht, die oben genannten und grundsätzlich mit KI verbundenen Probleme zu lösen, sodass Fehler aller Art schnellstmöglich erkannt werden. XAI beschäftigt sich dazu mit Methoden und Algorithmen, die dem Menschen Erklärungen liefern, wieso eine Entscheidung getroffen wurde.

"Der Mensch strebt nach Erkenntnis. Dieses Streben hat die Entwicklung von KI-Systemen maßgeblich begünstigt. Und nun, da wir ausgeklügelte intelligente Systeme erschaffen können, sollen wir dessen Entscheidungen plötzlich nicht mehr nachvollziehen können? Das widerspricht der ursprünglichen Motivation."

So wird erstmalig der:die Nutzer:in in den Prozess des maschinellen Lernens integriert und kann durch seine:ihre überlegenen kognitiven Fähigkeiten, wie zum Beispiel die der Generalisierung, aktiv zur Qualität des Systems beitragen. In dem Kontext der Entwicklung künstlicher Intelligenzen kann XAI als letzte Komponente bzw. dritte Generation betrachtet werden. Sie überbrückt die Kluft zwischen dem enormen Potenzial künstlicher Intelligenzen und deren unausweichlichen Risiken. Somit ermöglicht XAI den produktiven Einsatz von KI-Systemen.

"XAI kann als Add-On betrachtet werden: Bestehende Prozesse müssen nicht neu konzipiert werden, um von der neuen Technologie zu profitieren."

Ansprechperson

Tobias Goerke

Tel: +49 251 77777340

Die folgende Grafik veranschaulicht die komfortable Integration von Explainable AI: bestehende Prozesse können um eine XAI-Komponente erweitert werden. Dafür bedarf es keines aktiven Eingriffs in bestehende ML-Prozesse. Die gewonnenen Erkenntnisse dienen einerseits den Nutzer:innen und sorgen für Verständnis und Vertrauen. Andererseits können die Einsichten verwendet werden, um den Lernprozess mit den erlangten Einsichten zu ändern und zu verbessern.

6 x Nutzen durch wie XAI Verfahren

-

Vertrauen

Explainable AI ermöglicht die Validierung komplexer Modelle durch die menschliche Überprüfung ihrer Entscheidungsgrundlagen. Somit wird menschliche Expertise und algorithmische Effizienz vereinigt. Hierdurch können Nutzer:innen das Vertrauen in Modelle erlangen und diese produktiv einsetzen.

-

Zugänglichkeit

Um mit künstlichen Intelligenzen zu interagieren, war bisher zwingend Expert:innen-Wissen notwendig. XAI ermöglicht es erstmalig auch fachfremden Nutzer:innen, komplexe intelligente Systeme zu verstehen und auf Basis der erklärten Vorhersage Entscheidungen zu treffen.

-

Vergleichbarkeit

Durch XAI können verschiedenste Modelle, Ansätze und Konzepte verglichen werden. Dies wiederum ermöglicht, das für den Einsatzzweck beste Modell zu identifizieren und einzusetzen.

-

Inkrementelle Optimierung

Mit Explainable AI können Schwachstellen bestehender Modelle aufgedeckt und durch erneutes Training mit veränderten Parametern inkrementell verbessert werden.

-

Problemverständnis

XAI kann genutzt werden, um das Modell und das darunterliegende Problem zu verstehen und somit Informationen über die Struktur der vorliegenden Daten zu erlangen. Menschen können also lernen, was eine künstliche Intelligenz bereits verstanden hat und so ggf. neues Domänenverständnis erlangen.

-

Compliance

Europäische Datenschutzgesetze verschärfen ihre Stellung gegenüber dem breiten Einsatz künstlicher Intelligenzen. So ist es durch die aktuelle Fassung der DSGVO strittig, ob vollautomatisierte Entscheidungen über ein Individuum zulässig sind. Das sogenannte „right to explanation“ könnte den Einsatz des erklärbaren Maschinenlernens für eine Vielzahl intelligenter Systeme zwingend notwendig machen.

Mit dem Anchors-Algorithmus lässt sich Explainable AI erfolgreich umsetzen

Die Idee des erklärbaren Maschinenlernens ist nicht neu. Es wurde bereits eine Vielzahl verschiedener Algorithmen veröffentlicht, die jeweils unterschiedlichste Ansätze verfolgen, um den Nutzer:innen in den Prozess des maschinellen Lernens einzubeziehen. Die meisten dieser Verfahren sind jedoch praktisch von wenig Relevanz und/oder liefern mangelhafte Ergebnisse, die den Nutzer:innen geringen Erkenntnisgewinn liefern.

"Anchors errechnet die bedeutendsten Variablen durch systematisch effizientes Experimentieren und Ausprobieren."

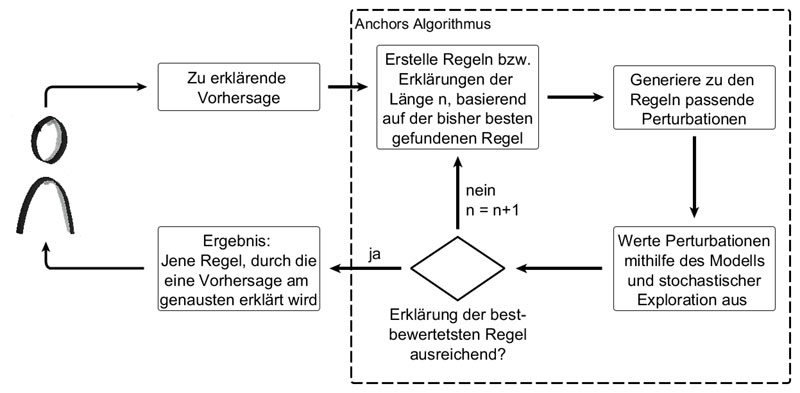

Besonders vielversprechend ist jedoch der im Jahr 2018 veröffentlichte Anchors-Algorithmus. Dieser kombiniert eine Reihe neuster Entwicklungen verschiedener Disziplinen und liefert auf konstanter Basis gut interpretierbare Ergebnisse. Anchors kann als lokal (liefert Erklärungen zu jeweils einer Vorhersage) und modell-agnostisch (kann jedes Modell erklären) klassifiziert werden. Seine Funktionsweise kann vereinfacht wie folgt dargestellt werden (s. u.): Durch die Nutzung von Perturbationen, das heißt kleine Manipulationen der ursprünglichen Instanz, kann der Inputbereich um die erklärte Instanz herum nachgebildet bzw. simuliert werden. Somit ist Anchors in der Lage, die Nachbarschaft einer Vorhersage zu erhalten. Aus dieser werden systematisch und stochastisch effizient Proben entnommen, welche Rückschlüsse auf die Gründe, also das Wieso der Entscheidung, zulassen.

Das folgende Video zeigt ein Beispiel solcher Perturbationen. In dem Einsatzszenario soll erklärt werden, wieso ein trainiertes neuronales Netz das Bild als „zeigt Banane“ klassifiziert. Dazu wird das Bild zunächst in Features unterteilt – hier dargestellt durch Pixel-Gruppen. Nun können Regeln erstellt werden, die jeweils eine bestimmte Anzahl Features fixieren. Die Instanz wird anschließend perturbiert, indem Features, die nicht in der Regel enthalten sind, randomisiert durch andere Pixel überlagert werden. Diese Perturbationen können nun durch das Modell klassifiziert, und dessen Vorhersage ausgewertet werden. Auf diese Weise können verschiedenste Regeln und ihre Aussagekraft überprüft werden. Daraus ergeben sich Rückschlüsse auf jene Features bzw. Pixel des Bildes, welche ausschlaggebend für die ursprüngliche Vorhersage sind.

Ansprechperson

Tobias Goerke

Tel: +49 251 77777340

Open Source für noch mehr Vertrauen in KI

viadee bietet das erste Open Source Anchors Framework

Durch seine Qualität und Effektivität ist Anchors für uns das Mittel der Wahl im Bereich XAI. Aus diesem Grund haben wir das erste Open Source Anchors Framework erstellt. Dieses setzt den Fokus auf Effizienz und Anwendbarkeit, sodass ein produktiver Einsatz bestmöglich ist. anchorj ist seit November 2018 ein frei zugängliches Projekt auf GitHub!

Es gibt viele XAI Methoden, mit unterschiedlichen Stärken, Schwächen und Voraussetzungen. Als Entscheidungshilfe für Ihre konkrete Situation bieten wir den XAI-Recommender (XAIR) zur freien Nutzung an. Wir freuen uns über Feedback und Community-Beiträge, die den Recommender mehr Methoden und Implementierungen lernen lassen.

viadee ist Wegbereiter im Umgang mit Methoden im Feld des erklärbaren Maschinenlernens

Wir sind überzeugt von dem Potenzial und der Relevanz von XAI und forschen daher aktiv an Möglichkeiten zur Einführung dieser neuen Technologie. Durch die schnelle Aufnahme der Forschung an der neuen Art von Algorithmen ist die viadee eines der führenden Unternehmen im Umgang mit Methoden im Feld des erklärbaren Maschinenlernens. Dabei ermöglicht die Quelloffenheit unserer Produkte die Einbindung externer Innovationen und Entwicklungen.

Aktuelle Forschungsschwerpunkte

- Globale Verfahren zur Erklärung des gesamten Modell-Inputbereiches

- Verfahren zur Parallelisierung für die Erzeugung performanter XAI-Systeme

- Musterverfahren zur schnellen Integration häufig verwendeter Einsatzszenarien

- Interaktive Erklärungen

Wäre es nicht schön, immer jemanden zur Hand zu haben, der gängige Explainable AI-Verfahren (XAI) wie SHAP-Values oder Counterfactual Explanations kennt und bei Bedarf anwenden kann? Der es einfach macht, mit einem ML-Modell zu spielen, um zu verstehen, wie es ‚tickt‘? Es wäre auch noch gut, wenn er beliebig viel Geduld hätte. Hier sieht man den Chatbot ERIC im Einsatz. Er ist aus einer Abschlussarbeit des F+E-Bereichs KI der viadee in Kooperation mit der WWU Münster hervorgegangen und erklärt hier einen Classifier für das beliebte Titanic-Dataset. Sprechen wir darüber?

Das folgende Material ist bereitgestellt im Rahmen des International Workshop on Explainability for Trustworthy ML Pipelines, Co-located with EDBT/ICDT 2020 Joint Conference

XAI und MLOps

Beide Ansätze tragen zur Nachvollziehbarkeit von Machine Learning Ansätzen bei, aber auf unterschiedlichen Ebenen.

Während XAI-Verfahren sehr fokussiert auf ein konkretes ML-Modell und dessen Verhalten sind, betrachten moderne MLOps-Verfahren und -Werkzeuge Nachvollziehbarkeit auf der Ebene eines Datenproduktes oder Projektes:

- Welche Modelle gibt es?

- Wie sind sie entstanden?

- Welche Daten wurden verwendet?

- Welche Qualitätssicherungsmaßnahmen und Freigaben sind erfolgt?

- Für produktive Modelle: Wie verändern sich die Aussagen des Modells über die Zeit?

Wer diese Fragen beantworten kann zahlt auch auf die XAI-Ziele ein. Wer sie nicht beantworten kann, der wird auch von XAI-Verfahren nicht profitieren können.